Con l’IA il software corre più dell’hardware. È la fine del personal computer?

Con l’avvento della rivoluzione dell’intelligenza artificiale, ci siamo accorti che la potenza di elaborazione dei computer non è cresciuta abbastanza in fretta, e ora il personal computer rischia di rimanere tagliato fuori. Siamo alle porte di una rivoluzione che però viene digerita a fatica da chi ha sempre visto nel personal computer un simbolo di libertà.

Se come me seguivate con attenzione il settore tecnologico tra la fine dello scorso decennio e l’inizio di quello corrente, è probabile che vi ricordiate quanto spesso ci venisse detto che l’hardware era diventato sovradimensionato rispetto al software. A ogni uscita di un nuovo prodotto, soprattutto quelli di alta gamma, ci siamo sentiti ripetere che, sì, in effetti c’era un aumento della potenza di calcolo, ma che in fondo questo aspetto non era poi così rilavante, perché la potenza era diventata a quel punto sufficiente per tutti, e non c’era, dicevano, più bisogno di ulteriori aumenti, se non nel gaming o in alcuni settori particolari. Questo perché, asserivano i profeti, avevamo raggiunto il tetto massimo di quello che persone comuni avrebbero mai potuto chiedere ai propri computer; anzi, pensa un po’, sembrava che i software dovessero diventare più leggeri, perché in fondo dovevano svolgere sempre le stesse funzioni. Se il polverone che si è sollevato nelle scorse settimane, quando si è scoperto che Discord si chiude automaticamente quando il consumo di RAM dell’app supera i 4 (leggere e scandire ad alta voce: quattro) GB, ha un minimo di fondamento (spoiler: lo ha), vuol dire che il libro del futuro a volte tende a divertirsi alle nostre spalle.

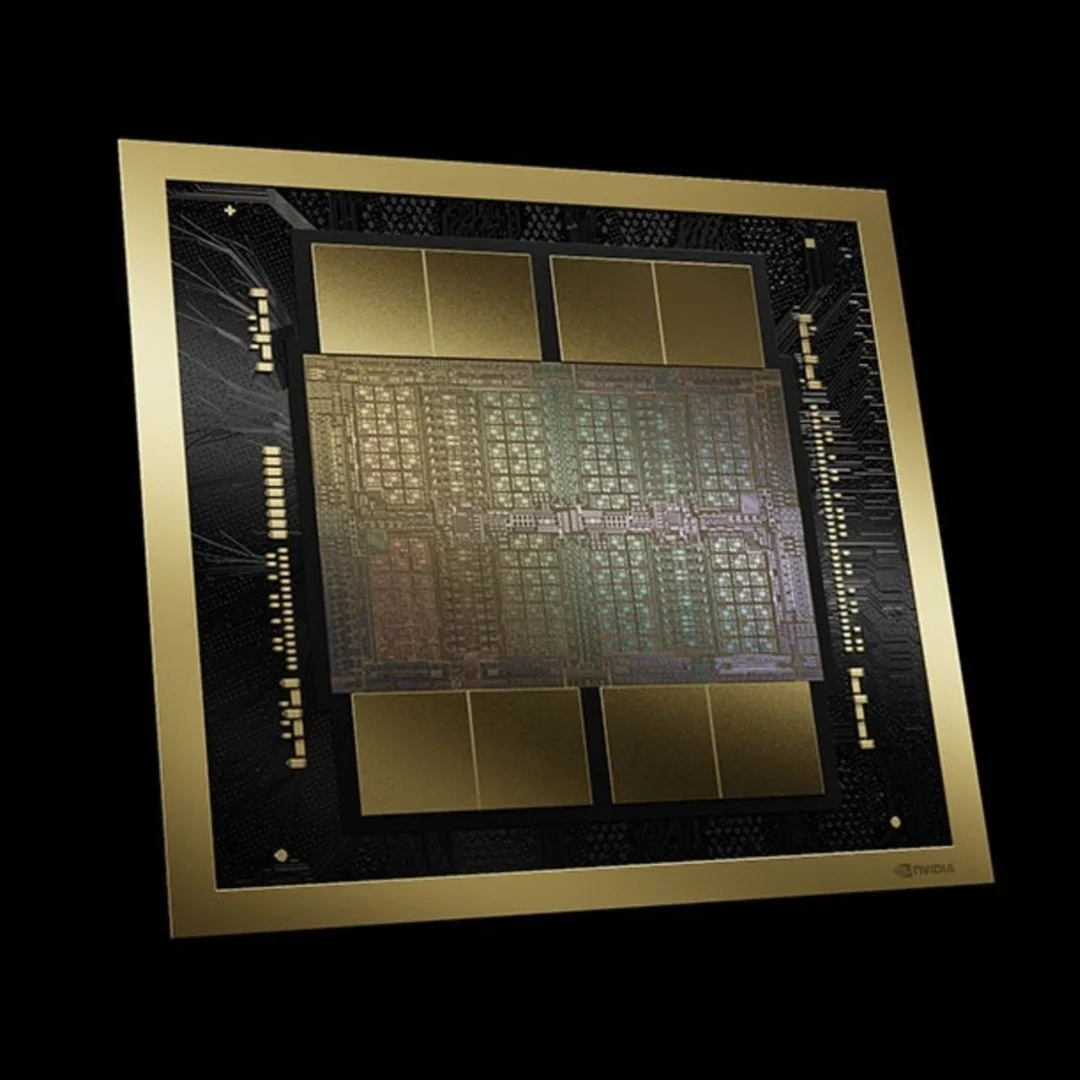

Ma soffermarsi sulle applicazioni poco ottimizzate, che comunque sono diffusissime e sono una piaga per il settore, è come guardare al dito e non alla luna. Luna che è rappresentata dalla rivoluzione dell’intelligenza artificiale, che mangia risorse di calcolo come se fosse il più veloce mangiatore di hot dog del mondo (che immagine orribile, la lasciamo nell’articolo definitivo?), e che non potrà mai accontentarsi di un device personale, ma vorrà sempre interi data center. Alla faccia di tutti quelli che dicevano che non serviva più potenza in locale.

D’altra parte, per lunghi decenni siamo stati abituati a vedere incrementi esponenziali nella potenza dei processori, grazie alla Legge di Moore; così abituati che ci siamo coccolati con questa magia costruendo chip sempre più densi e performanti, fino a quando l’incantesimo si è spezzato e siamo ripiombati con i piedi per terra, e con l’aggravante di aver costruito un’intera industria attorno a una legge empirica che era evidente non sarebbe durata in eterno. L’industria tecnologica però non si può fermare, e se non è possibile aumentare più di tanto le performance dei singoli chip di anno in anno, la soluzione non può che essere quella di metterne tanti a lavorare tutti insieme. Magari col tempo saremmo anche stati in grado di far girare gli attuali modelli in locale persino sui prodotti più economici, mentre oggi nemmeno i computer più carrozzati raggiungono le prestazioni del cloud, ma ci sarebbe voluto troppo tempo, e se il software è già pronto e gli investimenti sono già stati fatti, non ci si può fermare ad aspettare.

Quello di cui però molti non si sono accorti è che l’IA ha spalancato definitivamente una porta che aveva già iniziato a scricchiolare quando le persone si erano abituate a fruire dei media e a tenere i propri dati online: gradualmente sono sparite le collezioni di video e musica, poi anche i dischi di backup. Primo passo. Il secondo passo è quello che sta avvenendo ora, e che ha iniziato ad avvenire già da un po’ in alcuni settori: non sono più solo i dati a finire in cloud, ma anche la stessa elaborazione di questi dati. Gli studi e i professionisti che lavorano con asset 3D pesantissimi, per cinema, grafica e giochi, usando software come Octane, Maya o Unreal Engine, già da tempo si appoggiano per molti aspetti del loro lavoro alle renderfarm in cloud: si preferisce tenere le workstation più leggere e spostare in cloud i calcoli più pesanti, risparmiando tempo e denaro. Ora con l’IA questo paradigma è stato sdoganato anche sui comuni dispositivi personali, così chi usa i vari modelli si sta abituando a non avere più un software installato in locale sul proprio computer che svolge le elaborazioni di cui ha bisogno, ma un’applicazione che fa solo da interfaccia per un sistema che funziona grazie a server potenzialmente situati dall’altra parte del mondo. E non stiamo parlando solo di chatbot, perché sono sempre di più i software, anche professionali, che si appoggiano per alcune funzioni a modelli in cloud: la suite Adobe, giusto per fare un nome a caso, integra sempre più funzioni che difficilmente potrebbero girare in locale, ma che hanno semplificato di molto la vita a chi era costretto a svolgere attività ripetitive che ora sono automatizzate, così resta più tempo per la parte creativa del lavoro.

Ma, a mio parere, la vera rivoluzione nell’elaborazione in cloud, che è ancora agli albori ma potrebbe arrivare presto grazie alla porta aperta dall’IA, è quella delle applicazioni integrate nei chatbot. Qualcosa si è già visto nelle ultime presentazioni di OpenAI, anche se per ora si tratta di integrazioni piuttosto limitate. Tuttavia, da qui ad avere un modello che costruisce di volta in volta un’interfaccia personalizzata per interagire con l’applicazione il passo è breve, e a quel punto la potenza locale del computer diventerà sempre più marginale: i dati, le applicazioni, l’elaborazione vivranno e resteranno sempre in cloud per la maggior parte degli utenti casual che oggi non svolgono lavori professionali con il computer.

Insomma, in una visione di lungo periodo, siamo davanti a un cerchio che si sta chiudendo: i computer sono nati come grandi elaboratori che occupavano enormi stanze, con cui si poteva interagire attraverso i terminali collegati grazie al time-sharing. La rivoluzione che però ha portato i computer ovunque è stata quella dei computer personali, che quando ebbero raggiunto una potenza sufficiente per farci cose utili resero i grandi elaboratori degli strumenti sempre più di nicchia, almeno fino all’esplosione del web. Un web che oggi non è più un mero veicolo di informazione, ma la struttura su cui abbiamo costruito l’elaborazione in cloud. Ecco perché penso di potermi prendere la licenza di affermare che siamo davanti ai primi passi del “time-sharing” del XXI secolo: il personal computer ha fatto la sua epoca, e d’ora in avanti è lecito aspettarsi che per un numero crescente di scenari di utilizzo diventi sempre più un dispositivo leggero con il solo scopo di fare da interfaccia per un sistema che gira totalmente in cloud.

L’industria tecnologica è dunque ai blocchi di partenza di un cambiamento epocale, che promette grandi ritorni alle multinazionali e una soglia di accesso più bassa alle risorse computazionali per le persone. Per chi come me però è cresciuto vedendo nel personal computer uno strumento in grado di dare libertà all’individuo, come fu l’automobile qualche generazione fa, spero comprendiate che un pizzico di amarezza resta.